OpenAI放大招!GPT-4o震撼发布,速度更快、价格更亲民还能检测人的情绪

齐齐哈尔时尚网小编提示,记得把"OpenAI放大招!GPT-4o震撼发布,速度更快、价格更亲民还能检测人的情绪"分享给大家!

北京时间周二(5月14日)凌晨,美国人工智能研究公司OpenAI在线上举办了“春季更新”活动。

简要来说,OpenAI的发布会主要干了两件事情:发布最新GPT-4o多模态大模型,相较于GPT-4 Trubo速度更快、价格也更便宜。

第二件事情就是宣布,ChatGPT的免费用户也能用上最新发布的GPT-4o模型(更新前只能使用GPT-3.5),来进行数据分析、图像分析、互联网搜索、访问应用商店等操作。这也意味着GPT应用商店的开发者,将面对海量的新增用户。

当然,付费用户将会获得更高的消息限制(OpenAI说至少是5倍)。当免费用户用完消息数量后,ChatGPT将自动切换到GPT-3.5。

另外,OpenAI将在未来1个月左右向Plus用户推出基于GPT-4o改进的语音体验,目前GPT-4o的API并不包含语音功能。苹果电脑用户将迎来一款为macOS设计的ChatGPT桌面应用,用户可以通过快捷键“拍摄”桌面并向ChatGP提问,OpenAI表示,Windows版本将在今年晚些时候推出。

值得一提的是,公司首席技术官米拉·穆拉蒂在一次直播活动中表示:“这是我们第一次在易用性方面真正向前迈出了一大步。”

图片来源:视频截图

OpenAI由微软支持,目前投资者对其估值已超过800亿美元。该公司成立于2015年,目前正面临在生成式AI市场保持领先地位的压力,同时需要想方设法实现盈利,因为其在处理器和基础设施建设上投入了大量资金,以构建和训练其模型。

“O”是包罗万象的O

发布会刚开始,米拉·穆拉蒂为这次新发布定了调,说OpenAI的目标是进一步减小人们使用AI的障碍,让所有人都能在工作、学习、创造中用上AI工具。

为了这个目的,OpenAI做了三件事:发布更强大的模型GPT-4o,更新用户界面提高使用体验,然后一口气免费开放给用户。穆拉蒂补充道,付费用户享有五倍的使用容量限制。

据OpenAI表示,GPT-4o是一个“原生多模态”模型,它的命名来源于“omni”,即包罗万象之意。

比起此前要么是图文模式要么是语音模式的GPT-4,它更擅长打组合拳,可以接受文字、音频、图像的任意组合输入,然后无缝衔接图文音频的多种形式输出。

升级后的GPT-4o回答速度更快了。

据OpenAI表示,GPT-4想要实现和人的对话需要通过三步来实现:先把语音转换为文字,再生成回复文本,最后再转成语音。根据用户选择模型的不同,这个过程的平均延迟高达2.8秒 (GPT-3.5)和5.4 秒(GPT-4),对着手机屏幕等回复,跟GPT聊过天的朋友应该都有类似的体验。而且在语音转文字再转语音的过程中,很多信息损失了,GPT无法获得说话人的音调,也无法收取背景音,如果有多个人一起说话更是灾难性的场景。

“我们跨文本、视觉和音频端到端地训练了一个新模型,”OpenAI写道,“这意味着所有输入和输出都由同一神经网络处理。”现在的GPT-4o可以在最短232毫秒内响应对话,平均响应时间320毫秒,和人类的反应速度几乎一样,爱跟ChatGPT聊天的朋友终于可以从微信语音模式切换到日常交流模式了。

GPT-4o还带来了更好用的界面。

再也不用在网页间互相切换了,新的桌面版GPT可以融入任何工作流,随时和用户用图像文字语音进行交流,虽然还没用上,但可以想像这种工作体验有多快乐。

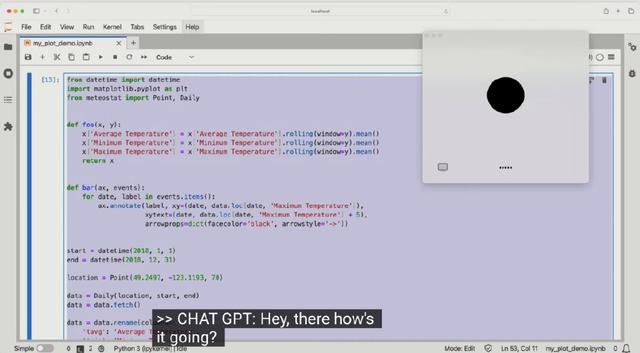

右上角是桌面版GPT的小窗口,可以贴代码让它debug,可以截图让它读表格,也可以随时跟它对话|@OpenAI

此外,萨姆·奥尔特曼在X上补充道,模型升级不止在GPT上,开发者也可以在API里同步使用GPT-4o,价格是GPT-4 Turbo的一半,速度是GPT-4 Turbo的两倍。GPT-4o还在50多种除英文外的语言能力上得到了加强。

连呼吸都能辨别

发布会的最后一个环节是实机演示。OpenAI麾下的大牛研究员Marc Chen和Barret Zoph一起展示了新模型的强大之处。

在第一段对话里,Chen对GPT说,自己有点紧张,然后开始急促地呼吸。GPT识别到了他呼吸的声音,说,别紧张,你喘得像个吸尘器,深呼吸,再吐气。接着GPT开始指导Chen怎么深吸慢呼平复心情。

这个demo设置得很妙,它展示出了两个重要的新能力:听环境音和即时反馈。

GPT不再需要一轮一轮地进行对话,它可以同时听人喘气和进行呼吸指导,输入和输出在同时发生。

第二个demo里,Chen让GPT给Zoph讲个睡前故事哄他入睡,Chen反复打断GPT的讲述,问它能不能讲得更刺激点,最后,GPT跟迪士尼公主似的把故事用歌唱了出来。

有时候GPT给人感觉话太多了,在新版本里,你要是不想听可以立刻打断或者提出意见,就像在真实生活里的交流一样。

后面的几个demo里,GPT教Zoph做了数学题(“你能不直接告诉我答案,而是启发我一步一步解完嘛?”),给大家解释了代码,读了图表,给Zoph看了面相(“你很开心,又有点激动。”),最后还当了Chen和穆拉蒂之间的同声传译。

对此,有网友表示太惊喜,“太像真人对话了” ……

(综合自每日经济新闻、新浪财经等)